Olá,

Eu sempre dou um exemplo simples: O arquivo Robots é uma especie de “porteiro” ou “controlador de acessos” de nosso site ou e-commerce.

Robots.txt é um arquivo que existe em todo diretório raiz de qualquer site existente e é o primeiro arquivo que os bots de busca procuram em um site.

O robots.txt vai controlar as informações que serão indexadas ou não pelos sites de busca. Visto “robots.txt” entende-se que o arquivo tem formato .txt, extensão de bloco de notas. Nele você tem a permissão de escolher os diretórios, arquivos e pastas que você deseja bloquear das ferramentas de busca. O uso mais comum é evitar indexação de páginas logadas ou que possuam arquivos privados.

Por se tratar de um arquivo MUITO importante, você deve ter muita atenção com a maneira que ele é configurado. Mas não fique preocupado, pois a TrayCommerce cuida muito bem deste arquivo, e tem as principais linhas para garantir o funcionamento.

Para vê-lo, digite: http://sualoja/robots.txt

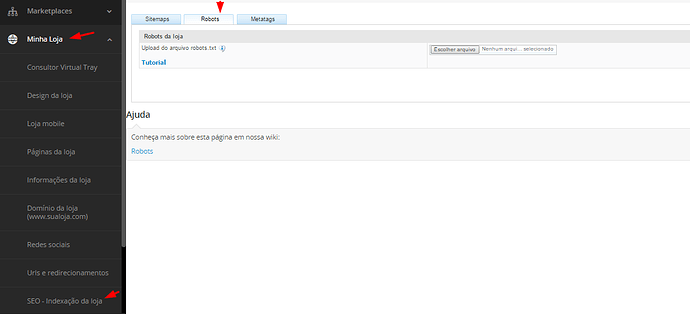

Para fazer a configuração do su arquivo robots.txt na Tray Commerce, basta seguir o caminho como na imagem abaixo:

Minha Loja → SEO Indexação da Loja → Selecione a Guia Robots.txt

Você precisa criar em seu computador um arquivo com o nome “robots.txt” e enviar na área de seleção;

A Sintaxe do arquivo robots.txt não é complexa, vamos a um breve exemplo:

USER-AGENT

A função do comando user-agent é listar quais robôs devem seguir as regras indicadas no arquivo robots.txt. Saiba como fazer isso na lista segmentada de robôs.Google: User-agent: Googlebot

Google Imagens: User-agent: Googlebot-images

Google Adwords: User-agent: Adsbot-Google

Google Adsense: User-agent: Mediapartners-Google

Yahoo: User-agent: Slurp

Bing: User-agent: Bingbot

Todos os mecanismos: User-agent: * (ou simplesmente não incluir o comando user-agent)

DISALLOW

O comando instrui os sites de busca sobre quais diretórios ou páginas não devem ser incluídas no índice. Exemplos:Disallow: /prod – orienta aos robots a não indexarem pastas ou arquivos que comecem com “prod”;

Disallow: /prod/ – orienta aos robots a não indexarem conteúdo dentro da pasta “prod”

Disallow: print1.html – orienta aos robots a não indexarem conteúdo da página print1.html.

ALLOW

O comando Allow orienta aos robots qual diretório ou página deve ter o conteúdo indexado. O Allow permite que seja indexado o diretório /about abaixo do diretório /catalogs.Disallow: /catalogs

Allow: /catalogs/about

Simples não?

Agora o seu arquivo robots deve ser desenhado de acordo com sua estrutura de pastas.

DICA IMPORTANTE: Sempre use Ferramentas de Webmaster para encontrar paginas e pastas para criar seu arquivo Robots.txt.

Um bom exemplo é a WebPeak, faça um live demo gratuitamente